Hai mai avuto la sensazione che dietro l’AI ci fosse qualcosa di magico, quasi esoterico, accessibile solo a pochi eletti?

I titoli gridano all’intelligenza che scrive come un umano, alla minaccia per i programmatori, al futuro già deciso.

Dentro di te cresce quella tensione tra curiosità e paura: e se fosse vero?

Se la macchina stesse davvero prendendo il mio posto?

Fermati un istante.

La verità è che non c’è magia, non c’è coscienza, non c’è pensiero.

Ci sono strumenti, proprio come in una cassetta degli attrezzi.

E tu, da sviluppatore, sai bene che gli strumenti, per quanto sofisticati, funzionano solo se qualcuno li sa usare.

L’AI non è un incantesimo, è un laboratorio di precisione fatto di pezzi che si incastrano, come ingranaggi che lavorano silenziosi.

Ogni tecnologia sufficientemente avanzata è indistinguibile dalla magia.Arthur C. Clarke - scrittore e futurologo britannico (1917–2008)

Ecco la promessa: alla fine di questo articolo sarai capace di guardare un modello di linguaggio senza timore reverenziale, riconoscendo ogni meccanismo per quello che è.

Non filosofia, ma concretezza.

Non fumo, ma attrezzi che puoi imparare a maneggiare.

Io stesso ho iniziato con dubbi simili ai tuoi.

Dopo oltre 25 anni come architetto software, dopo aver creato e ceduto aziende di successo e formato centinaia di sviluppatori, ho capito una cosa: la speranza non è vana.

Se impari a conoscere gli ingranaggi nascosti, avrai un vantaggio enorme su chi si limita a subire la rivoluzione.

Questa è la notizia che ti do: i modelli di linguaggio non pensano, non sognano, non creano.

Calcolano.

E lo fanno attraverso strumenti che chiunque può comprendere, se mostrati nel modo giusto.

È come scoprire che il prestigiatore non ha poteri, ma solo un set di trucchi ben allenati.

Ed è per questo che oggi ti guiderò dentro la cassetta invisibile che fa funzionare i modelli di linguaggio.

Pezzo per pezzo, attrezzo per attrezzo, fino a quando anche tu potrai vedere cosa c’è davvero sotto il cofano dell’intelligenza artificiale.

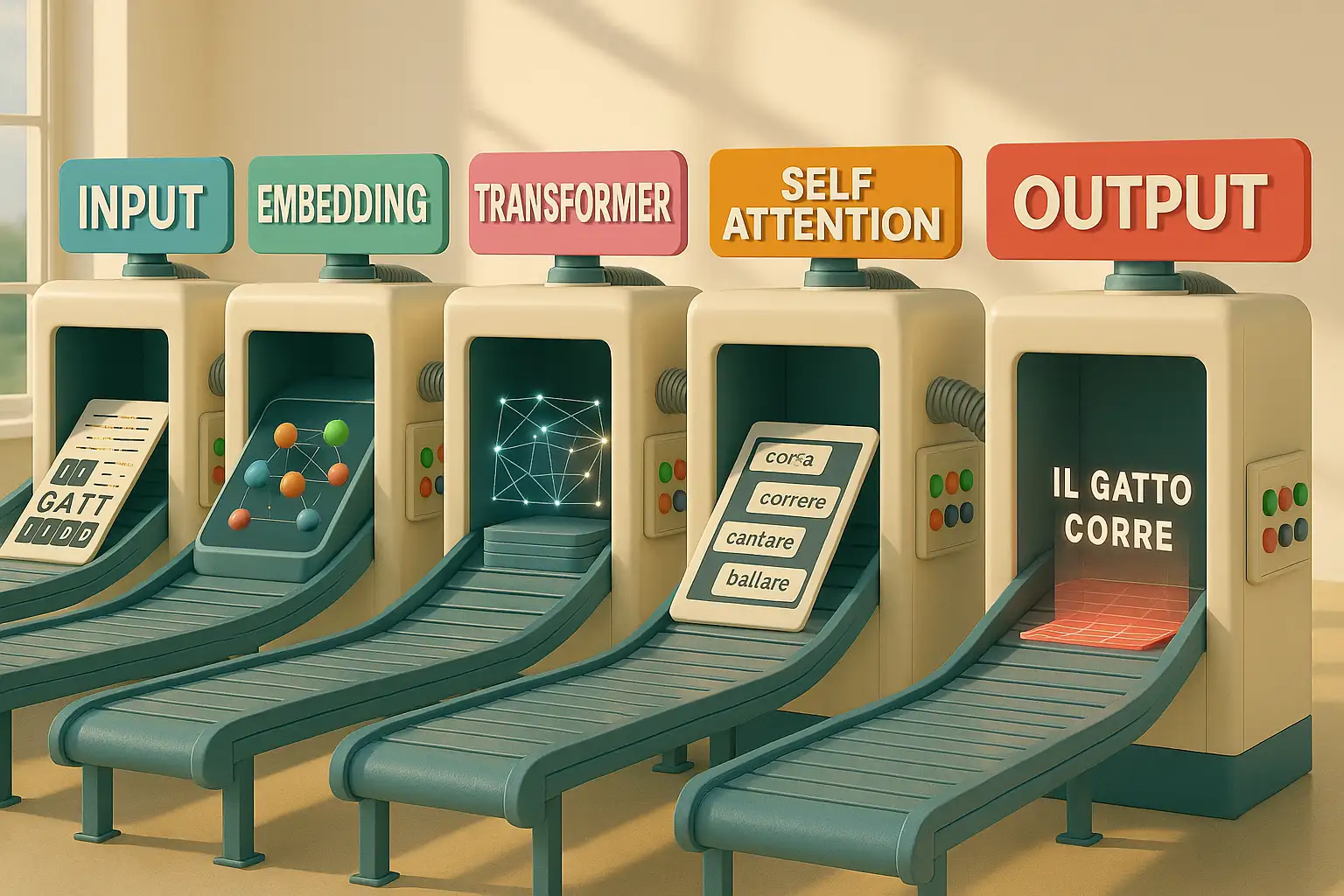

Come funziona davvero l’embedding delle parole

Immagina di aprire la cassetta e trovare un metro a nastro.

Sembra banale, ma senza di lui non puoi misurare nulla, non puoi costruire nulla.

L’embedding è esattamente questo: la misura della distanza tra le parole.

Non importa più che siano fatte di lettere o significati, importa solo come si posizionano in uno spazio numerico.

Ogni parola diventa un punto in una mappa invisibile:

- “Re” e “regina” finiscono vicini perché condividono molte caratteristiche

- “Cane” e “gatto” si trovano a poca distanza

- “Auto” e “banana” si perdono lontano nello spazio numerico

Non è comprensione, è geometria.

È come se ogni termine si trasformasse in coordinate che puoi tracciare su una griglia infinita.

Perché serve?

Perché i modelli non leggono come noi: confrontano numeri, calcolano relazioni.

Senza questo metro invisibile, il testo sarebbe solo caos.

Con l’embedding, invece, la macchina ha un criterio per dire: “queste due parole si somigliano, queste due no”.

Ed è lì che inizia a costruire.

Non serve credere alla magia: basta capire che tutto parte da un attrezzo semplice.

Un metro a nastro che non misura centimetri, ma significati numerici.

Senza di lui, la cassetta degli attrezzi sarebbe vuota.

Con lui, hai il primo passo per smontare il mito dell’intelligenza artificiale.

Perché la tokenizzazione spezza il testo in modi strani

Supponi, ora, di prendere in mano un cutter.

Non serve per misurare, ma per dividere.

La tokenizzazione è questo: un taglio netto che divide il testo in pezzi più piccoli.

Ma non aspettarti che i tagli seguano le regole a cui sei abituato.

Non è detto che la lama si fermi alla fine di una parola intera: a volte la divide a metà, altre la spezza in radici e suffissi.

Il motivo è semplice: il modello non ragiona con le stesse unità che usiamo noi.

Ha bisogno di segmenti più gestibili, ricorrenti e facili da combinare.

Un po’ come quando smonti un mobile: non lo dividi in assi enormi, lo separi in viti, cerniere e tavole.

Così, i token diventano i pezzi standard da riassemblare in mille modi diversi.

Per te, che leggi, “sviluppatore” è una parola intera, con un significato compatto.

Per la macchina, invece, potrebbe diventare “svilup” e “patore”.

Non è un errore, è un taglio funzionale: così il modello può gestire testi enormi con un vocabolario ridotto.

Certo, può sembrare strano vedere le parole frantumate, ma è proprio questa frammentazione che rende possibili combinazioni infinite.

Il taglierino non si preoccupa dell’eleganza: pensa solo a rendere i pezzi abbastanza piccoli da essere riutilizzati.

Così fa la tokenizzazione.

Senza di essi il modello resterebbe bloccato, incapace di lavorare sul linguaggio in modo efficiente.Una divisione che sembra brutale, ma che è indispensabile per costruire qualunque frase.

Non lasciarti confondere: non sei tu a sceglierli, ma puoi capire come funzionano.

Se impari a gestirli, trasformi questa apparente stranezza in un vantaggio.

Vuoi scoprire come?

Nel corso di programmazione con l’AI ti mostro passo dopo passo come farlo diventare un alleato.

Il positional encoding che mantiene l’ordine delle frasi

Pensa di avere sul banco un mucchio di assi di legno tutte uguali.

Se non ci metti un segno, come fai a sapere quale va prima e quale dopo?

Qui entra in gioco la livella.

Non quella che serve a controllare se il pavimento è dritto, ma quella che ti permette di mantenere l’allineamento.

Il positional encoding lavora così: mette un marchio su ogni pezzo, in modo che l’ordine non vada perso.

Per la macchina, senza questo segno, “Il cane morde l’uomo” e “L’uomo morde il cane” sarebbero identici.

I token sono gli stessi, ma l’ordine cambia tutto.

Mettere le cose nella giusta sequenza è la base di ogni comprensione.Ludwig Wittgenstein - filosofo austriaco-britannico (1889–1951)

Assicura che i pezzi si incastrino nella sequenza corretta, come quando monti una mensola e sai che la vite più lunga va in basso, non sopra.

Il trucco sta nel dare a ogni posizione un’impronta numerica.

Così il modello non solo riconosce i token, ma sa anche dove collocarli nella frase.

Non è intuizione, è pura organizzazione.

È il modo con cui il sistema tiene insieme la trama di un discorso, evitando che diventi un puzzle sparpagliato sul pavimento.

Quando guardi un testo scorrere da un modello, pensa a questa livella invisibile che lavora dietro le quinte.

Non ti accorgi di lei, ma senza, ogni parola sarebbe un pezzo perso, incapace di rispettare la logica della frase.

Il positional encoding è la garanzia che il tutto resti in equilibrio.

Fine tuning e RLHF quando l’uomo corregge la macchina

Riapri la cassetta e trovi una lima.

Non serve a costruire da zero, ma a rifinire.

Il fine tuning e il Reinforcement Learning from Human Feedback lavorano proprio così: prendono uno strumento grezzo e lo rendono più preciso, levigato, adatto a un compito specifico.

Un modello addestrato su enormi quantità di testo è come un coltello appena uscito dalla fucina: taglia, ma in modo grossolano.

Con il fine tuning lo specializzi: se vuoi un assistente per il codice:

- Se vuoi un assistente per il codice, lo alleni su repository di programmazioneSe vuoi un modello che risponda a domande legali, lo esponi a testi giuridiciSe vuoi un supporto per la scrittura creativa, lo abitui a racconti e dialoghi

Ogni passaggio lo affina, come colpi di lima su una superficie irregolare.

Poi c’è il RLHF, la correzione umana che aggiunge un altro livello.

Qui non parliamo di più dati, ma di preferenze.

Gli utenti valutano le risposte: questa va bene, questa no.

Il modello assimila i giudizi e aggiusta il suo comportamento, imparando a sembrare più naturale, più utile.

Non diventa più intelligente: si allinea meglio a ciò che ci aspettiamo.

Per te sviluppatore, la lezione è chiara: la macchina non migliora da sola, ma attraverso il lavoro umane che intervengono, correggono, plasmano.

Ogni volta che vedi un modello rispondere meglio di ieri, immagina una lima che ha smussato gli spigoli.

È un processo artigianale, anche se mascherato da tecnologia futuristica.

Context window il limite della memoria a breve termine

Ogni cassetta ha uno spazio limitato.

Puoi infilarci molti attrezzi, ma non tutti: prima o poi devi scegliere.

La context window funziona nello stesso modo: è la memoria a breve termine del modello.

Non importa quanto sia grande la sua rete, deve lavorare su un numero definito di token.

Questo significa che, mentre scrive, il modello ricorda solo un certo tratto del discorso.

Se la finestra è di poche migliaia di token, testi troppo lunghi si perdono: le prime frasi svaniscono, come se fossero state cancellate.

Non è un difetto accidentale, è un limite strutturale.

Per capire, immagina di lavorare su un progetto con una scatola di viti.

Se ne hai solo cento, puoi fissare i pezzi fino a un certo punto.

Se te ne servono di più, devi ricaricare.

Così fa il modello: ha una capienza massima, oltre la quale non può andare.

E per lo sviluppatore questa è una notizia importante: non puoi aspettarti che l’AI tenga insieme un intero libro senza perdere pezzi.

Devi imparare a lavorare con questo vincolo, spezzando i problemi in segmenti più piccoli.

La context window è un promemoria: anche il sistema più imponente ha i suoi limiti fisici.

La memoria è l’inchiostro della mente.

Aristotele - filosofo greco, (384 a.C.–322 a.C.)

Ogni modello ha i suoi limiti, ma chi li conosce può piegarli a proprio favore.

Se vuoi che l’AI diventi davvero il tuo alleato, devi sapere anche come aggirare la sua memoria corta.

Nel corso di programmazione con l’AI ti mostro passo dopo passo come farlo, prima che lo facciano i tuoi concorrenti.

Perché il prompt engineering cambia la qualità delle risposte

Prendi in mano un cacciavite.

Non importa quanto sia robusto, se lo usi male rovini la vite.

Il prompt engineering è questo: l’arte di usare lo strumento nel modo giusto.

Il modello risponde sempre in base a come lo istruisci, e la qualità della domanda determina la qualità della risposta.

Scrivere un prompt è come infilare la punta nel solco corretto; se sei impreciso, slitti e rovini il lavoro.

Se sei chiaro, ottieni un serraggio perfetto.

Ecco perché due sviluppatori, usando lo stesso modello, ottengono risultati opposti: non dipende dalla macchina, ma dalla mano che guida lo strumento.

Molti credono che basti chiedere, ma tu sai che ogni attrezzo ha la sua tecnica.

Se vuoi scrivere codice, devi specificare linguaggio, contesto e vincoli.

Se vuoi un riassunto, devi dire lunghezza, tono e scopo.

Ogni dettaglio aggiunto è come una pressione più decisa sul cacciavite, che ti avvicina al risultato desiderato.

Il modello non interpreta le tue intenzioni: segue le istruzioni numeriche che riceve.

E se impari a maneggiare il cacciavite del prompt engineering, scopri che la stessa macchina che sembrava inutile diventa improvvisamente affidabile.

Questa è competenza nell’uso dello strumento, non è magia.

Decoding il processo con cui il modello decide cosa scrivere

Adesso immagina di usare una chiave dinamometrica.

Non serve solo a stringere, ma a decidere con quanta forza farlo.

Il decoding funziona così: stabilisce, passo dopo passo, quale parola generare.

Ogni token non è scelto per ispirazione, ma per calcolo.

Il modello valuta probabilità: tra tutte le opzioni possibili, qual è la più adatta a seguire quella precedente?

A volte sceglie la più probabile, altre volte introduce variazioni.

È come decidere quanto stringere un bullone: troppo poco e si allenta, troppo e rischi di spezzarlo.

Questo processo invisibile è ciò che trasforma i numeri in frasi.

Non c’è intuizione, ma una sequenza di scelte probabilistiche.

Più conosci il meccanismo, più ti rendi conto che ogni parola scritta non è frutto di creatività, ma di calcolo sistematico.

Capire il decoding ti mette nella posizione di chi può prevedere e influenzare il comportamento del modello.

Non più spettatore, ma artigiano che sa dove applicare forza e dove lasciar spazio.

Ogni output diventa il risultato di un serraggio ben calibrato.

Greedy sampling e beam search tre modi diversi di generare testo

Nella cassetta trovi diverse punte da trapano.

Sembrano simili, ma ognuna lavora in un modo diverso.

Così fanno greedy sampling, beam search e altri metodi di generazione.

Sono strategie per decidere come esplorare le possibilità quando il modello scrive.

Il greedy sampling è la punta veloce: prende sempre l’opzione più probabile, senza esitazioni.

È rapido, ma rischia di produrre testi monotoni, sempre uguali.

La beam search è più prudente: esplora più strade contemporaneamente, valuta diverse sequenze e poi sceglie la migliore.

È lenta, ma produce risultati più raffinati.

Ci sono anche tecniche intermedie, che bilanciano velocità e varietà.

Per te, sviluppatore, questo significa che non tutte le risposte del modello nascono allo stesso modo.

Cambiare strategia è come cambiare punta: può sembrare un dettaglio, ma influenza l’intero lavoro.

Conoscere queste differenze ti libera dall’illusione che il testo generato sia sempre inevitabile.

In realtà, dietro ogni riga ci sono scelte precise, e tu puoi decidere quale strumento usare per ottenere l’effetto che cerchi, proprio come un artigiano che cambia punta per adattarsi al materiale.

Dietro ogni frase generata dall’AI non c’è magia, ma scelte matematiche che puoi guidare tu.

Se impari a maneggiare queste leve, il testo non sarà più casuale ma sotto il tuo controllo.

Vuoi imparare le tecniche che fanno la differenza?

Questo è il momento giusto per farlo con in nostro corso di programmazione con l’AI

Temperature e top k le manopole che regolano creatività e controllo

Ora hai davanti un trapano con due manopole: una regola la velocità, l’altra la precisione.

Temperature e top k sono queste manopole.

Non creano nulla da sole, ma cambiano radicalmente come il modello genera testo.

La Temperature stabilisce quanto il modello debba rischiare:

- Bassa temperatura: sceglie opzioni più probabili e produce testi sicuri ma prevedibili

- Alta temperatura: introduce varianti, a volte brillanti e creative, altre incoerenti

- Valori intermedi: bilanciano stabilità e originalità, modulando l’imprevedibilità

È come aumentare la velocità del trapano: più spinta, più imprevisti.

Il top k, invece, limita le scelte.

Dice al modello: “considera solo le k opzioni migliori”.

È il controllo che riduce il caos, restringendo il campo.

Più stringi, più sicura diventa la frase, ma meno creativa.

È la manopola della precisione.

Giocare con queste impostazioni significa decidere che tipo di testo vuoi.

Vuoi stabilità o inventiva?

Vuoi un manuale tecnico o un racconto fantasioso?

Ogni regolazione ti porta a un risultato diverso: non è una casualità, è controllo sugli strumenti.

Ed è qui che lo sviluppatore può davvero guidare l’AI, invece di subirla.

Perché alla fine l’AI è solo calcolo e non pensiero

Chiudi la cassetta.

Guardi gli attrezzi uno per uno: metro, cutter, livella, lima, cacciavite, chiave dinamometrica, punte e manopole.

Sono strumenti.

Precisi, indispensabili, ma privi di coscienza.

Nessuno di loro sa cosa stai costruendo.

Nessuno riflette.

E lo stesso vale per l’AI.

Dietro la facciata di frasi fluenti non c’è un pensiero che nasce, ma un insieme di calcoli che scorrono.

È potente, sì, ma è un meccanismo.

E come ogni meccanismo, ha senso solo nelle mani di chi sa usarlo.

Il computer è incredibilmente veloce, accurato e stupido; l’uomo è incredibilmente lento, impreciso e intelligente; insieme sono una forza che supera l’immaginazione.

Albert Einstein - fisico tedesco naturalizzato statunitense (1879–1955)Per te, sviluppatore, questa non è una minaccia.

È un’opportunità.

Significa che puoi capire l’AI, smontarla, maneggiarla come ogni altro strumento che hai incontrato nella tua carriera.

Non sei di fronte a un sostituto, sei di fronte a una nuova cassetta degli attrezzi.

E la differenza la farà sempre chi ci mette le mani sopra.

Finalmente, hai visto come è fatta “la cassetta degli attrezzi” al suo interno: nessuna magia, solo calcolo.

Ora hai due strade.

Restare spettatore, continuando a guardare l’AI come un mistero che avanza… oppure entrare in officina e imparare a usarla per scrivere codice, progettare soluzioni e guidare il cambiamento invece di subirlo.

Non hai più scuse.

Il momento per decidere è adesso.

Ogni giorno che aspetti, altri imparano a maneggiare questi strumenti e costruiscono il loro futuro.

Tu rischi di restare indietro.

La buona notizia è che puoi imparare a gestirlo: con il corso di programmazione con l’AI trasformi i dubbi in competenze concrete e inizi a usare l’AI con sicurezza.

Non è un corso teorico da manuale, ma un percorso che ti mette subito in mano gli attrezzi giusti, ti insegna a usarli e ti porta dall’altra parte della barricata: da chi subisce la rivoluzione a chi la guida.

Il mio corso è la tua unica arma per ribaltare la situazione: non ti promette teorie, ma ti porta direttamente dentro al meccanismo dell’AI e ti insegna ad azionarlo correttamente.

Non cliccare se ti accontenti di fare lo spettatore.

Clicca solo se sei pronto a prendere in mano la tua carriera.