Quando un algoritmo prende una decisione che ti riguarda, hai il diritto di sapere perché lo ha fatto e su quali basi ha costruito quel risultato.

Accettare un verdetto automatico significa rinunciare a capire e rinunciare a capire significa perdere il controllo sulla tua stessa vita.

Non basta sapere che un sistema funziona se non possiamo comprendere il percorso logico che ha portato a quel risultato e verificarne la coerenza.

La spiegabilità non è un vezzo tecnico, ma un'esigenza concreta per evitare che l'intelligenza artificiale diventi un'autorità opaca ed inaccessibile.

Dietro ogni previsione c'è una persona, dietro ogni valutazione c'è un impatto reale ed ogni algoritmo dovrebbe essere in grado di raccontarsi.

La trasparenza è l'unico modo per costruire fiducia ed ogni modello che prende decisioni deve poter esporre il suo ragionamento in modo chiaro.

Non è solo una questione di etica o di legalità, ma di funzionalità e responsabilità per chi progetta, per chi usa e per chi subisce ogni scelta automatica.

Se un medico non può comprendere perché un'IA propone una diagnosi, allora quella diagnosi diventa sospetta anche se statisticamente corretta.

Se un cliente viene rifiutato da una banca senza spiegazione, non solo perde fiducia nel servizio ma anche la possibilità di rimediare in futuro.

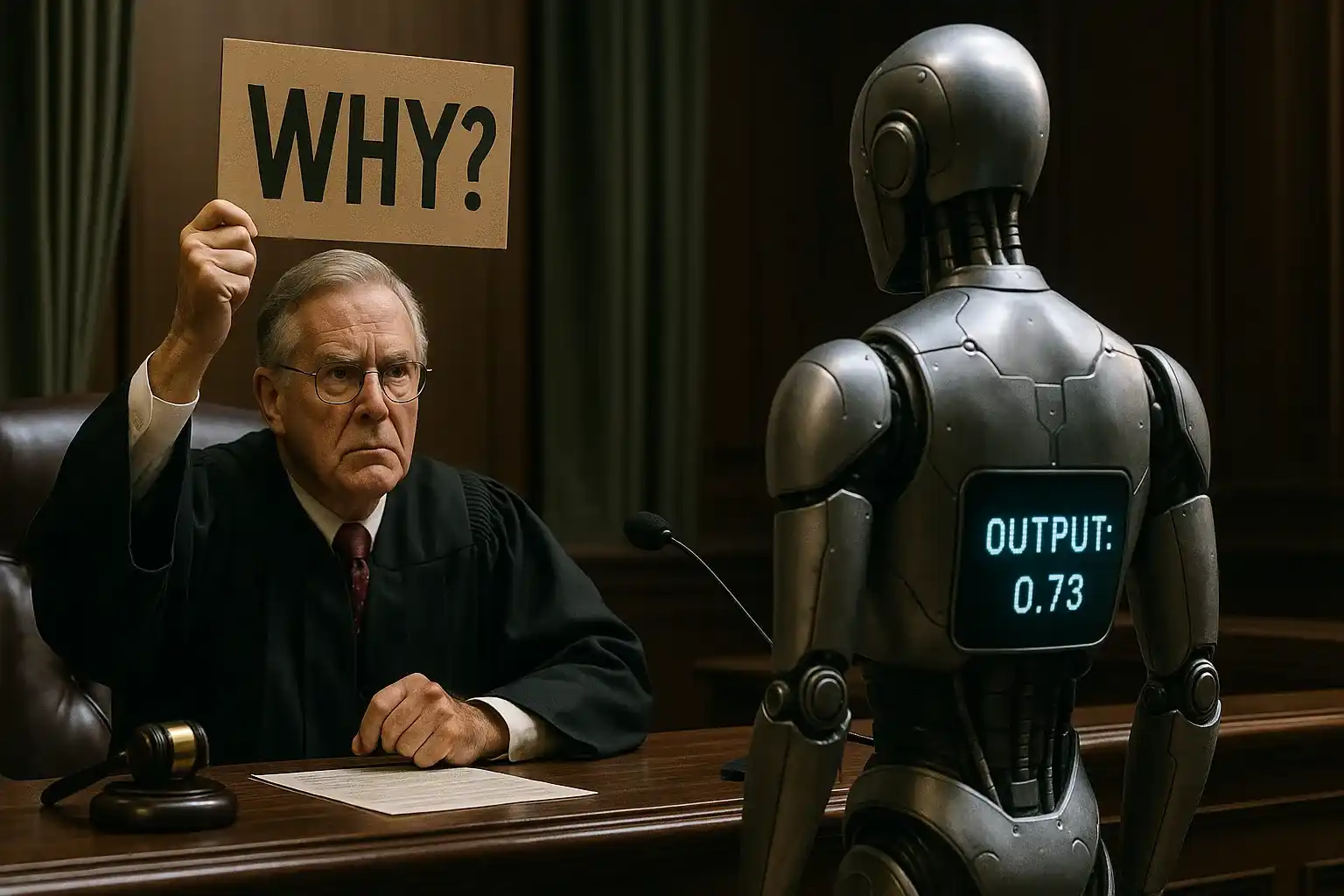

E se un cittadino viene classificato come rischio giudiziario da un algoritmo che non parla, siamo di fronte a un potere che non risponde a nessuno.

Explainable AI non è un'idea astratta, ma una necessità concreta per rendere ogni sistema decisionale trasparente, discutibile e perfezionabile.

In questo articolo scoprirai perché la spiegabilità è fondamentale, in quali ambiti è richiesta, come si costruisce e quali tecniche la rendono reale.

Vedrai le differenze tra modelli opachi e modelli leggibili, le implicazioni nei settori regolati e un esempio concreto per visualizzare le decisioni.

Se vuoi che la tecnologia sia davvero utile, deve essere anche comprensibile perché solo ciò che si capisce si può migliorare o rifiutare.

Molti corsi ti spiegano cos’è l’Explainable AI, ma noi andiamo oltre: ti insegniamo come applicarla, passo dopo passo, nei tuoi progetti, nei tuoi flussi decisionali e nella comunicazione verso chi userà il tuo modello.

Perché la trasparenza nei modelli di IA è cruciale

L'intelligenza artificiale non decide da sola, esegue istruzioni complesse che spesso nascono da dati distorti o non rappresentativi della realtà.

Quando un modello prende decisioni, il risultato può influenzare una diagnosi, un'assunzione, un prestito, un diritto o un'opportunità importante.

Se il processo che ha prodotto quella decisione è poco chiaro, nessuno può dire se ha agito in modo giusto, sbagliato o persino discriminatorio, senza rendersene conto.

Un algoritmo non è imparziale per natura, riflette ciò che ha imparato, quindi può amplificare pregiudizi, errori o squilibri presenti nei dati storici.

La mancanza di trasparenza non è solo un problema etico, ma rappresenta un rischio economico concreto per le organizzazioni che implementano sistemi di IA.

Ogni decisione automatica non spiegabile può trasformarsi in una causa legale, una multa normativa o una crisi reputazionale che costa molto più di quanto si risparmi evitando la spiegabilità.

Le aziende che hanno implementato sistemi non interpretabili, si trovano spesso a dover giustificare decisioni senza avere gli strumenti per farlo, creando contenziosi costosi e perdite di fiducia.

Quando un cliente non capisce perché è stato penalizzato, non solo cambia fornitore, ma condivide la sua esperienza negativa, amplificando il danno attraverso il passaparola digitale.

I team che lavorano con modelli non spiegabili perdono tempo prezioso cercando di interpretare risultati anomali, rallentando processi e riducendo la produttività complessiva.

La trasparenza serve a capire se una decisione è fondata, se le variabili usate sono corrette e se l'output ha un significato coerente con il contesto.

Quando manca la trasparenza, non c'è modo di spiegare un rifiuto, un'accusa o una raccomandazione e questo genera sfiducia, paura e conflitto.

Un sistema trasparente permette di contestare, correggere, comprendere e perfino migliorare le previsioni attraverso un dialogo tra uomo e macchina.

La trasparenza consente anche ai team di sviluppo di individuare anomalie, correggere errori e prevenire derive pericolose prima che diventino sistemiche.

La trasparenza, invece, accelera il troubleshooting, facilita la manutenzione del sistema e permette miglioramenti mirati che aumentano le performance nel tempo.

Le organizzazioni trasparenti costruiscono ecosistemi digitali più sostenibili, dove ogni stakeholder può contribuire al miglioramento continuo perché comprende come funzionano i processi automatici.

Investire in spiegabilità significa investire in resilienza organizzativa, perché un sistema comprensibile è più facile da adattare, correggere e far evolvere insieme al business.

Le decisioni automatiche non devono essere accettate per autorità, ma per comprensione e solo la trasparenza permette questo tipo di fiducia attiva.

Quando un modello mostra come è arrivato ad un risultato, diventa uno strumento di supporto e non un'entità che impone il proprio giudizio senza replica.

Se il processo è leggibile, allora anche l'errore può essere istruttivo e le persone coinvolte possono agire con maggiore consapevolezza e responsabilità.

Un sistema trasparente rafforza il rapporto tra tecnologia e società, trasformando la paura del nuovo in partecipazione consapevole e fiduciosa.

La trasparenza diventa così un vantaggio competitivo, non solo un obbligo, perché permette di costruire prodotti più affidabili e relazioni più solide con clienti e partner.

Se anche tu credi che dietro ogni algoritmo ci debba essere una logica chiara, questo è il momento di agire.

Con il nostro corso imparerai a costruire soluzioni trasparenti ed affidabili, pensate per adattarsi al tuo contesto reale e creare fiducia nel tuo dominio applicativo.

Nessuna proposta preconfezionata, solo un dialogo su misura per te.

La fiducia nei tuoi modelli non si impone, si conquista.

Lascia i tuoi dati, ti ricontatteremo per una call gratuita dove, insieme ad uno dei nostri consulenti, analizzerai i tuoi obiettivi.

Smetti di delegare alla cieca; inizia a decidere con consapevolezza.

Cos'è l'Explainable AI e in quali ambiti è richiesta

L'Explainable AI è una disciplina che si occupa di rendere comprensibili i processi decisionali dell'intelligenza artificiale a persone reali.

Non si tratta di semplificare un algoritmo, ma di mostrare in modo chiaro perché è stata fatta una scelta specifica tra molte possibili alternative.

Spiegare non vuol dire ridurre la potenza di un modello, ma renderla accessibile affinché l'utente possa fidarsi e agire in modo più informato.

Ogni sistema decisionale automatico dovrebbe potersi raccontare, perché una decisione cieca è pericolosa, soprattutto se ha impatto sulla vita delle persone.

La spiegabilità non è un concetto unico, ma si declina in forme diverse a seconda di cosa vogliamo capire e a chi dobbiamo comunicarlo.

- Spiegabilità globaleRisponde alla domanda: “Come funziona questo modello in generale?”Offre una visione d’insieme utile a chi deve valutare l’affidabilità del sistema.È il riferimento per i responsabili che devono verificare se il modello è coerente con le politiche aziendali e libero da bias sistematici.Un esempio concreto: un modello di credit scoring può dare più peso al reddito che all’età, privilegiando così fattori economici rispetto a quelli demografici.La spiegabilità globale, quindi, serve a chi governa il sistema e ha il compito di garantirne la correttezza strutturale.

- Spiegabilità localeSi concentra su una singola decisione e risponde alla domanda: “Perché il modello ha preso questa specifica decisione per questo caso?”È il tipo di spiegazione più importante per chi riceve il risultato perché permette di comprendere cosa ha influenzato direttamente la propria situazione.Se Mario Rossi viene rifiutato per un prestito, la spiegazione locale chiarisce che la causa sono i ritardi nei pagamenti recenti, non altri fattori come il codice fiscale o la residenza.La spiegabilità locale è dunque fondamentale per chi subisce la decisione e vuole comprendere il giudizio ricevuto.

- Spiegabilità controfattualeVa oltre e risponde alla domanda: “Cosa dovrebbe cambiare perché la decisione sia diversa?”Questo approccio è potente perché non si limita a descrivere il presente, ma suggerisce una via concreta per migliorare il risultato futuro.Proseguendo con l’esempio di Mario, la spiegazione controfattuale potrebbe indicare che se riuscisse a migliorare il suo score creditizio di 50 punti nei prossimi sei mesi, il prestito verrebbe approvato.È la forma di spiegabilità più utile per chi desidera modificare l’esito ottenuto e cerca indicazioni su come farlo in modo efficace.

In ambito medico, sapere che un modello ha suggerito una diagnosi è utile solo se possiamo capire quali sintomi lo hanno portato a quel risultato.

In ambito finanziario, un cliente ha diritto di sapere perché il suo profilo è stato considerato rischioso e quali fattori lo hanno penalizzato.

In ambito giudiziario, l'uso delI’ IA può supportare analisi, ma ogni decisione deve essere spiegabile per essere giusta, equa e legalmente accettabile.

L'Explainable AI fornisce strumenti e metodi per visualizzare l'importanza delle variabili, spiegare le scelte e simulare cambiamenti nel comportamento.

Può essere applicata anche in contesti non regolati, come il marketing, l'e-commerce o l'educazione, dove la fiducia degli utenti è comunque essenziale.

Ogni volta che un modello propone, raccomanda o giudica, è utile sapere da cosa nasce quella proposta, perché la comprensione crea valore e stabilità.

I metodi XAI aiutano anche i team di sviluppo a capire cosa sta succedendo dentro modelli complessi, migliorandone la qualità e riducendo i rischi.

I sistemi XAI più completi riescono a combinare tutti e tre i livelli, offrendo spiegazioni adattate al ruolo, al momento e agli obiettivi di chi le riceve.

Durante la progettazione è più utile la spiegabilità globale, in fase operativa serve quella locale, mentre la controfattuale è essenziale per guidare miglioramenti reali.

L'Explainable AI non è un lusso per pochi esperti, ma una base solida per costruire sistemi che funzionano meglio perché si fanno capire da tutti.

Se anche tu lavori con modelli che non riesci a interpretare davvero, è il momento di cambiare.

Non devi rinunciare alla potenza, ma nemmeno accettare l’oscurità come prezzo da pagare.

I nostri consulenti ed il nostro corso ti mostrano come valutare e applicare le soluzioni più adatte al tuo contesto, dominio e obiettivo, senza compromettere potenza o performance.

Scoprirai come integrare la spiegabilità senza rallentare la performance.

Lascia i tuoi dati: ti ricontatteremo per una call gratuita, dove analizzeremo il tuo sistema e troveremo il punto di equilibrio più sicuro.

La tua IA non deve essere una magia.

Deve essere uno strumento che risponde, spiega e cresce con te.

Black box vs white box: il problema dei modelli opachi

Molti modelli di intelligenza artificiale sono black box, cioè, funzionano, ma non sappiamo esattamente come prendano ogni singola decisione.

Un modello opaco può avere un'accuratezza altissima, ma se non possiamo capirlo diventa inutilizzabile in contesti dove il "perché" conta davvero.

Un sistema che non si lascia spiegare è un rischio, perché può produrre decisioni scorrette o discriminatorie senza che nessuno se ne accorga.

Al contrario, un modello white box è progettato per essere leggibile e trasparente anche se magari rinuncia a un po' di precisione statistica.

L'esempio più chiaro è tra una rete neurale profonda e un albero decisionale: la prima è potente, il secondo è leggibile anche da un non tecnico.

La sfida è scegliere il giusto equilibrio tra accuratezza e trasparenza, senza cedere del tutto né al fascino della performance né alla facilità d'uso.

Nel mondo reale, la cecità è un problema: se non sappiamo spiegare un risultato, non possiamo né difenderlo né correggerlo né migliorarlo.

I modelli opachi sono più difficili da controllare, soprattutto quando imparano da soli e modificano il proprio comportamento in tempo reale.

Questo rende impossibile garantire la coerenza etica o legale delle decisioni prese, soprattutto se coinvolgono salute, denaro o libertà personale.

I modelli leggibili, anche se meno precisi, sono spesso più sicuri perché si possono esaminare, testare e migliorare senza perdere il controllo.

L'obiettivo dell'Explainable AI è proprio questo: trasformare ogni black box in una struttura almeno parzialmente comprensibile e verificabile.

Se capiamo cosa accade dentro il modello, possiamo anche capire quando fidarci, quando dubitare e quando cambiare rotta senza paura.

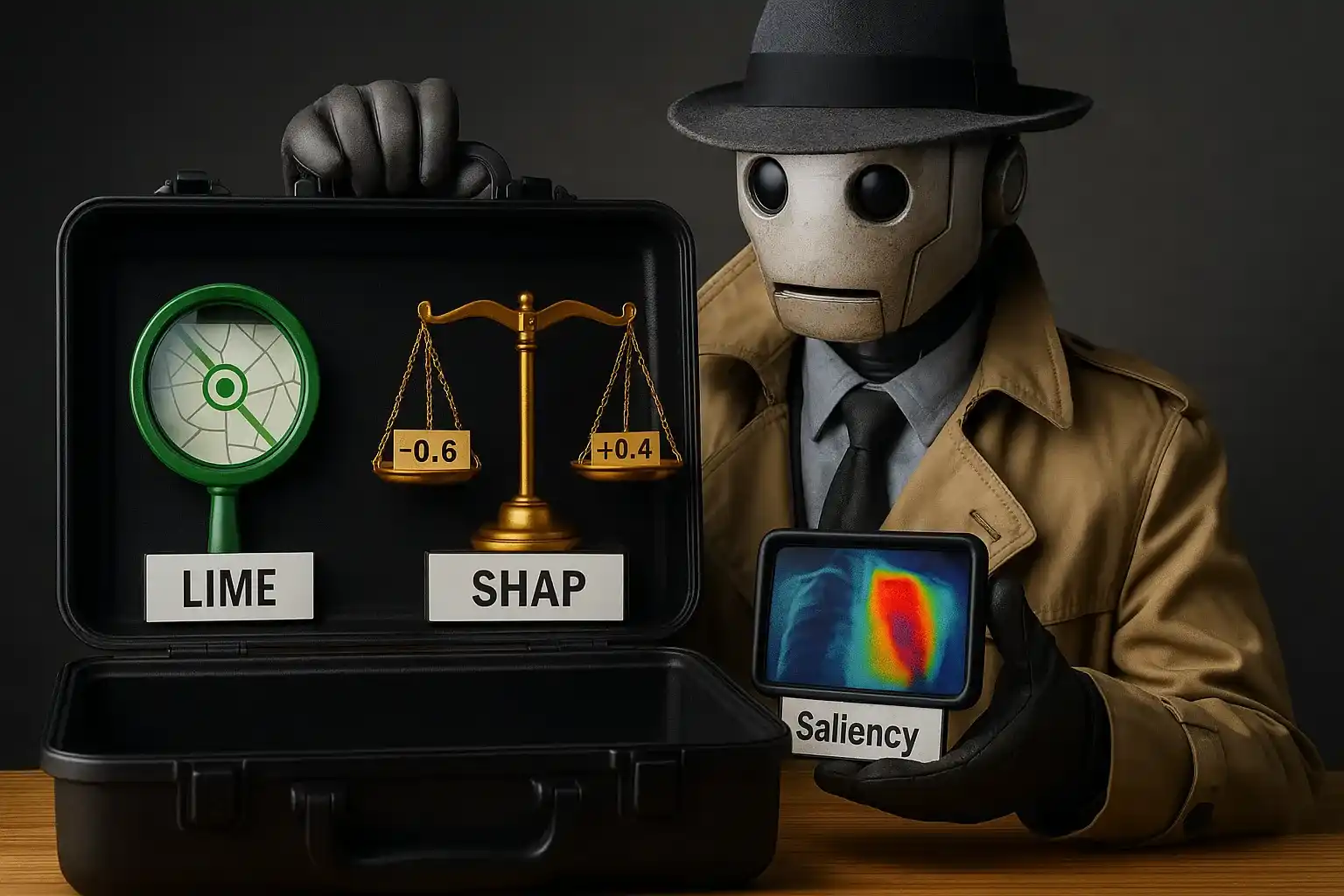

Tecniche per interpretare modelli complessi: LIME, SHAP, Saliency maps

Capire un modello complesso non è facile, ma alcune tecniche moderne ci aiutano a spiegare il comportamento anche dei sistemi più nebulosi.

Vediamo cosa contraddistingue ciascuna tecnica: anche solo capirne i principi può aiutare a scegliere quella più adatta al proprio modello:

- LIME (Local Interpretable Model-Agnostic Explanations)Evidenzia quali feature influenzano una specifica predizione.LIME è una di queste tecniche: spiega una singola decisione costruendo un piccolo modello semplificato attorno a quell’unico punto da analizzare.Serve per capire quali feature, cioè quali input, hanno influenzato una previsione, mostrando come una scelta è stata costruita in modo locale.Non spiega l’intero sistema, ma dà una fotografia dettagliata di un singolo caso e questo rende l’output più leggibile anche da chi non è esperto.

- SHAP (SHapley Additive exPlanations)Quantifica il contributo di ogni feature sulla previsione complessiva.SHAP funziona diversamente: si basa sulla teoria dei giochi e assegna a ogni variabile un contributo preciso nel determinare l’output finale.Questa tecnica permette di capire, per ogni predizione, quanto ha pesato ciascun dato e rende facile confrontare casi simili tra loro.

- Saliency mapsMostrano visivamente quali parti dell’input pesano di più sulla decisione del modello.Le saliency maps sono invece usate nel campo della visione artificiale e mostrano visivamente su quali zone dell’immagine si è concentrato il modello.Se un sistema riconosce un tumore, la saliency map ti fa vedere quali pixel hanno influenzato davvero la classificazione e dove ha "guardato" l’IA.Questo è fondamentale per dare fiducia ai medici, perché possono verificare se l’IA sta notando segnali coerenti con l’esperienza clinica.

Tutte queste tecniche non rendono perfettamente leggibili i modelli complessi, ma aprono finestre di comprensione che prima non esistevano affatto.

Mostrano che anche un sistema opaco può spiegarsi, se aiutato dagli strumenti giusti e se progettato con l’utente umano sempre al centro.

Nel nostro corso non ti limiti a imparare queste tecniche: capisci anche quando usarle, con chi condividerle e come trasformarle in valore concreto per i tuoi clienti.

Quando un algoritmo sa spiegarsi, diventa uno strumento utile, non solo potente, e trasforma la complessità in una risorsa, non in un rischio.

Come spiegare decisioni automatiche a utenti non tecnici

Spiegare una decisione presa da un algoritmo a chi non è tecnico non significa semplificare tutto, ma trovare parole che rendano comprensibile il processo.

Chi riceve una decisione ha bisogno di sapere perché è stata presa, cosa l'ha influenzata e se c'è modo di cambiarla o contestarla in modo chiaro.

L'utente comune non vuole il codice, vuole il senso e ha bisogno di sentire che dietro la decisione c'è un filo logico, non una risposta generata a caso.

Per questo la spiegabilità non può restare solo nei grafici o nei numeri, ma deve tradursi in frasi, metafore, esempi e visualizzazioni intuitive.

Un buon sistema XAI dovrebbe generare spiegazioni con frasi semplici e dirette, come: "Questa previsione si basa su tre fattori principali".

O ancora: "Il tuo profilo è stato valutato come a rischio perché ci sono ritardi nei pagamenti e mancano garanzie sufficienti a copertura".

Così l'utente sa cosa è successo e può decidere come reagire e un sistema che si spiega genera meno paura, più fiducia e maggiore senso di controllo.

Spiegare non è solo una questione tecnica, ma un atto di rispetto e chi riceve la decisione deve percepirla come giustificata e non imposta.

I progettisti devono quindi pensare alle interfacce, al tono della comunicazione, alla possibilità di approfondire senza sentirsi esclusi.

Ecco alcuni accorgimenti pratici per rendere la spiegazione algoritmica accessibile anche a chi non ha competenze tecniche:

Ecco alcune buone pratiche che aiutano a spiegare le decisioni anche a chi non ha competenze tecniche:

- Evita gergo tecnico che può spaventare o confondere

- Spiega con esempi concreti, non solo definizioni astratte

- Collega ogni decisione a una logica evidente

- Offri un contesto: perché questa scelta e non un’altra

- Usa analogie comprensibili, come confronti con situazioni reali

- Permetti all’utente di porre domande o chiedere chiarimenti

Non serve mostrare tutti i dettagli, ma solo quelli utili e rilevanti per l'utente, in base al contesto e all'impatto che la decisione avrà su di lui.

Un sistema che comunica bene le proprie scelte è anche più facile da correggere, perché rende evidenti i punti critici e le cause di eventuali errori.

Spiegare ai non tecnici è uno dei tratti distintivi dell'intelligenza vera, quella che non si nasconde dietro i numeri, ma costruisce relazioni chiare.

Se spiegare ti sembra difficile, non sei solo.

Ma esistono metodi, strategie e strumenti per rendere ogni decisione leggibile anche agli occhi meno esperti.

Nel nostro corso imparerai come rendere la tua IA comprensibile a chi ne subisce gli effetti, senza perdere potenza o rigore.

Ti accompagniamo passo dopo passo per creare interfacce, messaggi e logiche facilmente comprensibili, senza sacrificare la potenza del sistema.

Prenota una call e scopri come possiamo aiutarti a rendere i tuoi modelli più comprensibili, affidabili e vicini alle persone.

Lascia i tuoi dati ora e parliamone.

XAI in ambiti regolati: sanità, finanza, giustizia

In alcuni settori, spiegare le decisioni automatiche non è un'opzione, ma un obbligo e ogni scelta deve essere tracciabile, chiara e comprensibile.

Nel campo sanitario, un'IA che propone una diagnosi deve mostrare quali sintomi o parametri clinici hanno spinto verso quella specifica conclusione.

Un medico non può fidarsi di un sistema che non sa spiegare ed un paziente ha diritto di sapere su quali basi è stata costruita una diagnosi.

Anche quando l'algoritmo ha ragione, se non riesce a raccontarsi, rischia di essere ignorato, contestato o addirittura bloccato dai protocolli.

In finanza, un algoritmo che rifiuta un prestito deve spiegare il perché, indicando le variabili che hanno influenzato negativamente la valutazione.

Un cliente escluso senza spiegazioni può sentirsi discriminato o ingiustamente penalizzato, con conseguenze legali e reputazionali per l'azienda.

In ambito legale, la trasparenza è ancora più importante, perché ogni previsione automatica può influenzare la libertà o il trattamento di una persona.

Sistemi che valutano il rischio di recidiva o suggeriscono pene devono giustificare ogni calcolo in modo leggibile per tutte le parti coinvolte.

Se un giudice legge un punteggio senza capire da dove arriva, non può usarlo con serenità e l'imputato non può difendersi da un algoritmo cieco.

Per questo le normative stanno evolvendo per imporre la spiegabilità, come condizione necessaria per l'uso dell'IA nei settori ad alto impatto.

Il panorama delle regolamentazioni sull'IA spiegabile sta rapidamente evolvendo, con l'Europa in prima linea nella definizione di standard globali di trasparenza.

Il GDPR aveva già introdotto il concetto di "diritto alla spiegazione" per le decisioni automatizzate, ma l'AI Act europeo va molto oltre, definendo obblighi specifici per i sistemi ad alto rischio.

Secondo la nuova normativa, i sistemi di IA usati in settori critici devono essere progettati con trasparenza nativa, non come aggiunta successiva.

Le banche stanno investendo milioni per rendere i loro algoritmi di credit scoring conformi alle nuove regole, implementando dashboard che spiegano ogni decisione in tempo reale.

Gli ospedali pionieri hanno già creato protocolli dove ogni suggerimento diagnostico dell'IA viene accompagnato da spiegazioni che il medico può condividere con il paziente.

Il costo della compliance può sembrare alto inizialmente, ma le organizzazioni che si adeguano per prime ottengono vantaggi competitivi significativi nel lungo termine.

I clienti preferiscono sempre più fornitori che sanno spiegare le loro decisioni automatiche, trasformando la trasparenza in un differenziale di mercato.

Le aziende che aspettano l'ultimo momento per conformarsi rischiano non solo multe, ma anche di perdere quote di mercato a favore di competitor più trasparenti.

Il futuro delle regolamentazioni XAI punta verso standard internazionali armonizzati, dove la spiegabilità diventerà un requisito universale per l'IA in produzione.

Prepararsi oggi significa costruire un vantaggio sostenibile domani, perché la trasparenza non è solo un obbligo normativo, ma una necessità di business.

XAI non è più solo una buona pratica, ma una tutela per tutti, perché protegge il diritto alla comprensione, alla replica e alla trasparenza piena.

Un sistema che sa spiegarsi è anche più sicuro, perché può essere auditato, validato, migliorato e reso compatibile con regole e aspettative umane.

Implementare XAI non è solo un problema tecnico, ma richiede un cambiamento culturale che coinvolge tutta l'organizzazione, dal management ai team operativi.

Il primo passo è educare i leader aziendali al suo valore strategico, mostrando come la trasparenza riduca i rischi e migliori le performance complessive.

Molti manager vedono XAI come un costo aggiuntivo, senza realizzare che un sistema spiegabile è più facile da manutenere, debuggare e migliorare nel tempo.

È importante creare occasioni di formazione dove il personale non tecnico possa capire cosa significa "decisione algoritmica" e perché dovrebbe essere trasparente.

I team di vendita devono saper spiegare ai clienti come funzionano i sistemi automatici che li riguardano, trasformando la trasparenza in un punto di forza commerciale.

Il servizio clienti deve essere formato per gestire domande sulla logica degli algoritmi, offrendo risposte chiare invece di nascondersi dietro la complessità tecnica.

Anche i processi interni devono evolvere: ogni nuovo progetto di IA dovrebbe includere una valutazione della spiegabilità fin dalla fase di progettazione.

È utile creare comitati misti con rappresentanti tecnici e di business, che possano valutare insieme se un sistema è abbastanza trasparente per il suo scopo.

La resistenza al cambiamento è normale, soprattutto da parte di chi teme che la trasparenza possa rallentare l'innovazione o esporre debolezze del sistema.

Per gestire questa resistenza, è importante mostrare casi di successo concreti, dove la spiegabilità ha migliorato i risultati invece di limitarli.

Le metriche sono fondamentali: bisogna misurare non solo l'accuratezza dei modelli, ma anche la soddisfazione degli utenti, la riduzione dei contenziosi e il tempo di risoluzione dei problemi.

Costruire una cultura XAI significa trasformare la trasparenza da obbligo in opportunità, da vincolo in vantaggio competitivo sostenibile.

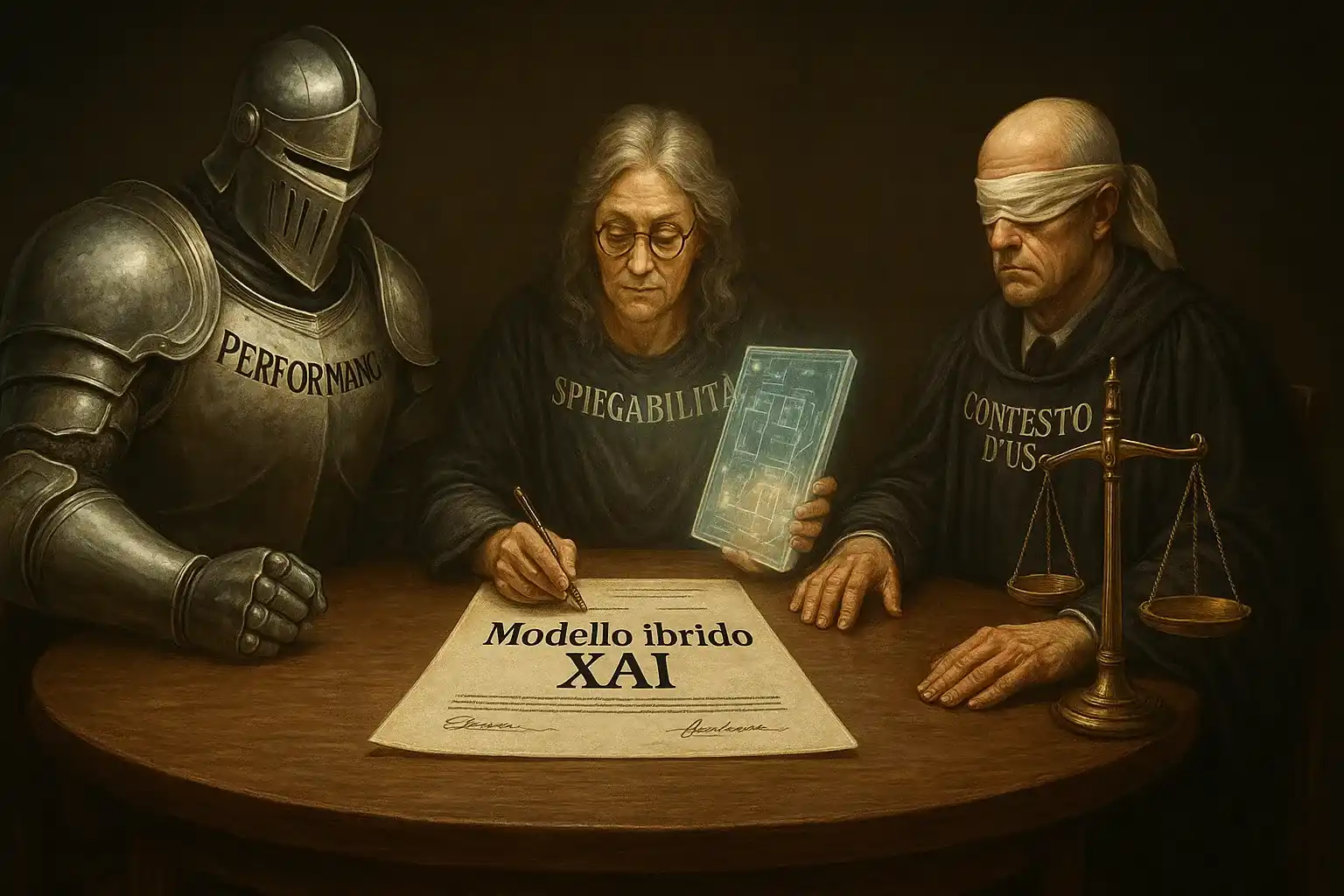

Sfide attuali: accuratezza vs interpretabilità

L'intelligenza artificiale più potente spesso funziona in modi troppo complessi per essere spiegati in modo diretto e questo crea un grande problema.

Se un modello è accurato ma incomprensibile, non possiamo sapere perché fa certe scelte, né possiamo verificarle o discuterle con sicurezza.

In contesti sensibili, la precisione non basta e non può sostituire la trasparenza, soprattutto quando le decisioni hanno impatto sulle persone.

La sfida più grande oggi è questa: come possiamo creare modelli che siano sia precisi che spiegabili, senza dover rinunciare a una delle due cose.

- Modelli complessi come le reti neurali profondeFunzionano molto bene, ma al loro interno ci sono migliaia di parametri impossibili da analizzare a mano.Questo li rende molto efficaci per certi compiti, ma poco adatti per ambienti dove la spiegazione è un requisito fondamentale per operare.

- Modelli più semplici, come quelli lineari o basati su regole chiareSono spiegabili, ma spesso meno performanti su dati complessi o rumorosi.La loro trasparenza è un vantaggio, ma può venire a scapito della precisione in situazioni più articolate.

- La tentazione di privilegiare sempre l’accuratezzaPorta a scegliere modelli opachi che funzionano bene, ma che non possiamo controllare.Se il risultato è incomprensibile, si rischia di perdere il controllo sul sistema e sulle sue decisioni.

- La valutazione del contesto d’uso diventa crucialeLe organizzazioni devono chiedersi se vale la pena sacrificare un po’ di accuratezza per ottenere trasparenza.La risposta dipende dall’ambiente in cui opera il modello e dalle conseguenze che derivano dalle sue decisioni.

È qui che si delineano tre approcci distinti, ciascuno con una propria visione del compromesso tra performance e spiegabilità:

- Favorire l’accuratezza: accettare modelli non chiari se migliorano le performance

- Favorire la spiegabilità: preferire modelli interpretabili anche a costo di precisione

- Cercare equilibrio: adottare soluzioni ibride e controllabili senza perdere efficacia

In alcuni casi, può essere preferibile avere un sistema leggermente meno preciso ma più leggibile, in grado di dialogare con l’essere umano.

Oggi la ricerca in XAI lavora proprio su questo punto: trovare tecniche che permettano ai modelli complessi di spiegarsi senza perdere potenza.

Il futuro appartiene ai sistemi ibridi, capaci di bilanciare efficacia e leggibilità, potenza e responsabilità, previsione e comprensione.

Noi crediamo che non si debba scegliere tra potenza e chiarezza.

Esistono soluzioni per costruire modelli che funzionano e si spiegano.

Parla con uno dei nostri esperti: troveremo insieme la strada migliore per integrare spiegabilità e precisione senza compromessi.

Non lasciarti frenare dal dubbio.

Compila il form ora e organizzeremo una call gratuita su misura per te.

Integrazione della spiegabilità nello sviluppo dei modelli

La spiegabilità non deve arrivare alla fine del progetto, ma deve essere presente fin dal primo momento in cui si definisce cosa costruire.

Se la pensi come una funzione extra, ti ritroverai a dover giustificare un sistema che non è stato progettato per parlare con l'esterno.

I migliori risultati arrivano quando la spiegabilità è integrata nel design, nelle scelte iniziali, nella logica di ogni fase del ciclo di vita.

Questo significa scegliere dati chiari, variabili leggibili, tecniche di modellazione compatibili con le esigenze comunicative dell'utente finale.

Significa anche progettare interfacce che aiutino le persone a interpretare le decisioni, non solo a riceverle come risposte senza volto.

Se sai già chi dovrà usare il sistema, puoi anche capire come dovrà spiegarsi e adattare ogni dettaglio per rispettare quella aspettativa.

I team che integrano XAI sin dall'inizio costruiscono sistemi più robusti, più facili da testare, più semplici da correggere e più sicuri nel tempo.

Per farlo servono azioni pratiche e scelte progettuali coerenti. Ecco i passaggi fondamentali da integrare nello sviluppo:

- Definire obiettivi esplicativi prima ancora di scegliere il modello

- Usare modelli o tool compatibili con l’XAI

- Costruire output pensati anche per utenti non tecnici

- Testare le spiegazioni, non solo le previsioni

- Includere ruoli umani nella revisione dei risultati

Ogni scelta tecnica può essere pensata anche in chiave narrativa: questa funzione a cosa serve, cosa influisce, cosa racconta del comportamento.

Includere la spiegabilità nello sviluppo non rallenta il processo, anzi previene errori, rende più fluido il lavoro e aumenta la qualità finale.

Permette di collaborare meglio con figure non tecniche, facilita i controlli interni e offre più valore ai clienti che devono fidarsi del sistema.

Il segreto è non trattarla come un lusso, ma come un requisito, come lo sono la sicurezza, l'accessibilità o la stabilità in produzione.

Chi progetta con trasparenza in mente crea prodotti che durano, che si evolvono con meno sforzo e che generano fiducia, non solo risultati.

Ecco come strutturare un ciclo di sviluppo che integri la spiegabilità fin dall’inizio.

Esempio pratico: visualizzare l'importanza delle feature in un modello predittivo

Immagina un modello che prevede se un cliente abbandonerà un servizio nei prossimi mesi in base al suo comportamento, storico e livello di interazione.

Il modello può essere accurato, ma se non sa spiegare le sue scelte, il team che deve intervenire non sa dove agire o cosa migliorare davvero.

Con una tecnica XAI come SHAP, puoi vedere per ogni singolo cliente quali fattori hanno pesato di più nella valutazione del rischio di abbandono.

Il sistema può dirti che per il cliente Mario Rossi contano molto i reclami recenti, la durata delle chiamate e la mancanza di accessi recenti.

In questo modo, chi gestisce il rapporto può intervenire in modo mirato, offrire assistenza o fare una proposta utile prima che sia troppo tardi.

Questa è la forza della spiegabilità: trasforma una previsione in un'opportunità, una risposta in una strategia concreta per migliorare il servizio.

La visualizzazione delle feature aiuta anche a confrontare casi simili e capire se il modello è coerente o se sta esagerando in certe direzioni.

Se un gruppo riceve sistematicamente punteggi peggiori, puoi indagare e scoprire se c'è un bias nei dati o nel modo in cui sono stati trattati.

Puoi anche creare dashboard per i manager, in cui ogni previsione viene accompagnata da spiegazioni leggibili, grafiche e facili da interpretare.

Questo aumenta la fiducia nei dati, migliora la qualità delle decisioni e riduce l'attrito tra tecnici, analisti, manager e responsabili operativi.

L'esempio è chiaro: un modello che si sa spiegare rende tutti più forti e consapevoli e quando tutti capiscono, tutti possono contribuire meglio.

Un importante ospedale milanese ha implementato un sistema XAI per la diagnosi precoce delle polmoniti, ottenendo risultati che vanno oltre la semplice accuratezza.

Il sistema non solo identifica i casi sospetti con il 94% di precisione, ma mostra ai radiologi esattamente quali aree dell'immagine hanno influenzato la diagnosi.

Questo ha aumentato la fiducia dei medici nel sistema e ridotto del 40% il tempo necessario per confermare o smentire i suggerimenti automatici.

I pazienti ricevono spiegazioni più chiare sulle loro condizioni, perché i medici possono mostrare visivamente cosa ha rilevato l'IA e perché è importante.

Nel settore bancario, una fintech italiana ha sviluppato dashboard XAI che spiegano in tempo reale perché un prestito viene approvato o rifiutato.

I clienti vedono immediatamente quali fattori hanno influenzato la decisione e ricevono suggerimenti concreti per migliorare il loro profilo creditizio.

Il risultato è stato una riduzione del 60% dei reclami e un aumento del 25% delle richieste di prestito, perché i clienti si sentono più informati e guidati.

La dashboard ha anche aiutato il team interno a individuare bias nel modello, correggendo algoritmi che penalizzavano ingiustamente certe categorie di utenti.

Implementare XAI non è mai un progetto a costo zero, ma questi esempi mostrano che il ritorno sull'investimento è misurabile e sostanziale.

La chiave del successo è sempre la stessa: progettare la spiegabilità per le persone che devono usarla, non per impressionare altri tecnici.

Quando la trasparenza diventa funzionale, diventa anche redditizia, trasformando un obbligo normativo in un vantaggio competitivo concreto e duraturo.

Chi ha seguito il nostro corso ha già applicato queste tecniche in contesti reali: dashboard bancarie più chiare, modelli clinici più trasparenti, sistemi decisionali più comprensibili per gli utenti finali.

Non è teoria: è pratica concreta che fa la differenza.

La vera intelligenza non è solo calcolare meglio, ma anche raccontare come si è arrivati a quel calcolo, perché senza spiegazione non c'è fiducia.

In ogni ambito della vita, accettiamo decisioni solo quando le capiamo e un algoritmo, per essere accettato, deve comportarsi nello stesso modo.

Spiegare non è un lusso, è un dovere e oggi chi progetta sistemi intelligenti ha la responsabilità di renderli comprensibili e umanamente accessibili.

XAI non è una moda tecnica, è la base per costruire un futuro in cui le macchine collaborano con noi senza sostituire il nostro giudizio critico.

Ogni modello che si racconta ci aiuta a fidarci, a correggere, a migliorare e rende la tecnologia un alleato, non un giudice silenzioso e distante.

Se hai letto fin qui, forse anche tu senti che non possiamo più accontentarci di sistemi chiusi che "funzionano", ma non sanno spiegarsi davvero.

Il prossimo passo tocca a te: come utente, come sviluppatore, come decision maker, puoi iniziare a chiedere più trasparenza e più chiarezza.

Ogni domanda che fai, ogni richiesta di spiegazione, ogni dubbio espresso è un passo verso un'intelligenza artificiale più vicina all'intelligenza vera.

Non lasciare che sia il sistema a dettare tutte le regole: oggi puoi partecipare, influenzare, scegliere modelli che ti parlano, non che ti comandano.

Il potere di capire è il potere di scegliere e quando la tecnologia diventa leggibile, diventa anche più giusta, più forte, più utile per tutti noi.

E adesso chiediti: cosa succede se non fai nulla?

Se continui a usare modelli che non parlano, stai costruendo un potere che non puoi controllare.

Ogni decisione opaca che lasci passare è una bomba a orologeria contro la fiducia dei tuoi utenti.

Ogni algoritmo muto che distribuisci può diventare una causa legale, una crisi reputazionale, un errore irreversibile.

E quando ti chiederanno spiegazioni, non avrai niente da dire.

Non aspettare il momento in cui dovrai giustificare l’ingiustificabile.

Fermati ora, prima che sia troppo tardi.

Parla con noi: ti aiuteremo a rendere trasparenti i tuoi sistemi, prima che diventino ingovernabili.

Partecipa al nostro corso e scopri come rendere trasparenti i tuoi sistemi prima che diventino ingovernabili.

Impara con esempi concreti, tecniche efficaci e strategie che puoi applicare subito.

Compila il form e prenota una call gratuita: ti spiegheremo come ti possiamo può aiutare, passo dopo passo, a costruire sistemi più affidabili, leggibili e vicini a chi li usa.

Oppure continua a sperare che nessuno chieda: “Perché?”